本帖最后由 网仙 于 2024-11-19 14:27 编辑

20241118补充

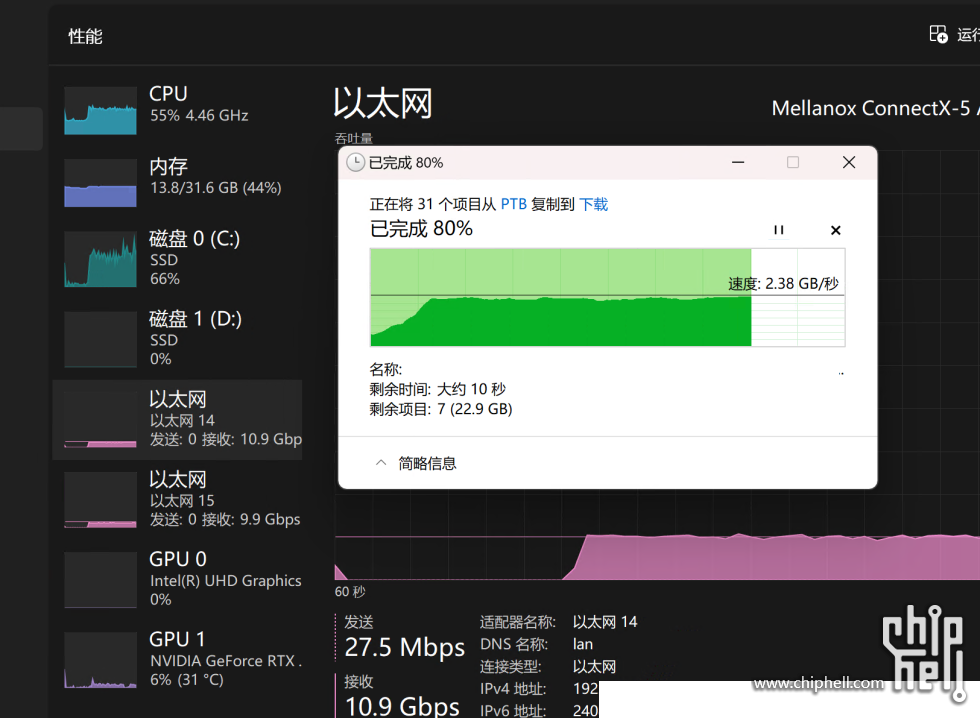

双25G,samba3多线程,往群晖写入最大可以到2.4GB/S左右。没有RDMA加持的群晖,这大概是其网络界面的极限速度了。

=================================

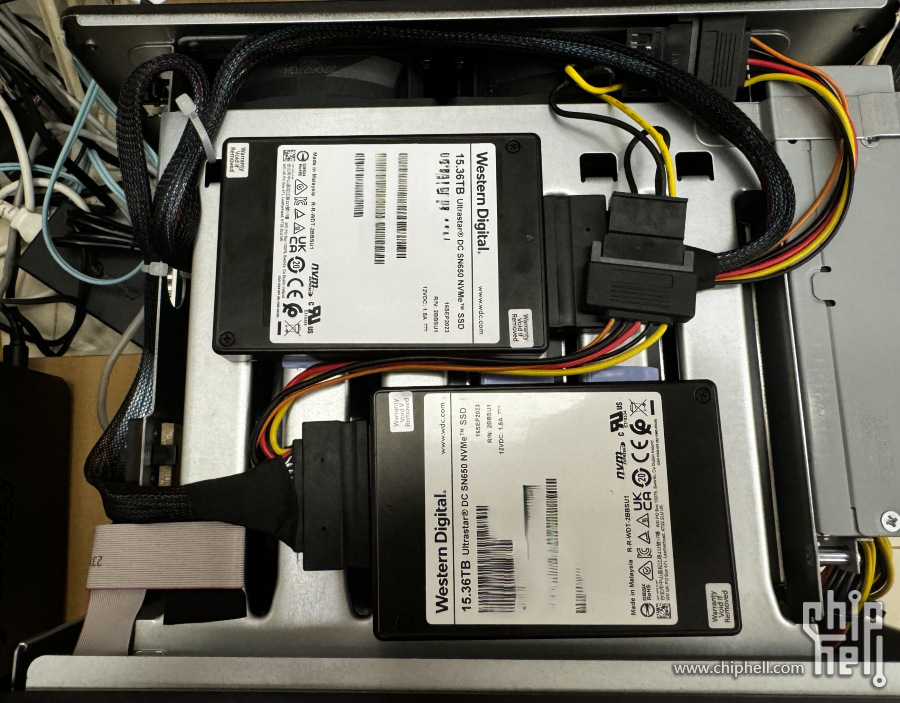

这台1621+应该算是满配的,6x20TB(WD-hc560)raid5 + 2xSN650(U.2)raid0;

QLogic的25G光卡,32GB*2内存ecc;测试了一下速度(MTU1500默认)

HDD阵列的极限能力(写入图,读取差不多)

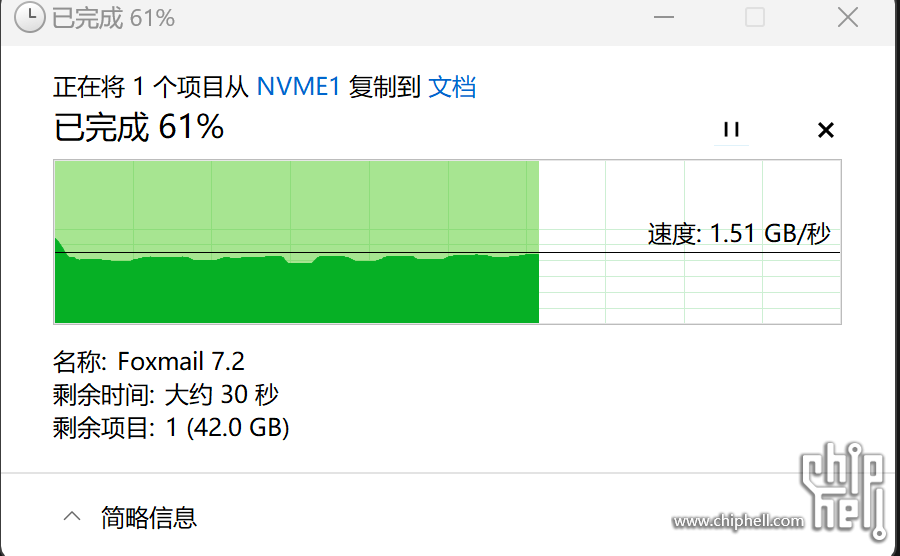

SSD阵列的极限能力(读取图,写入差不多):

首先,群晖比较扯淡的是不支持RDMA(ROCE);这个对SMB的性能表现非常不利。

根据上图的测试:

hdd部分,应该已经是到了机械盘的满载状态(1.1GB/S左右),其他位置没有形成瓶颈。刚好喂饱10G网络。

ssd阵列目前还有点疑问,因为群晖的M.2给的是pcie3.0,2X的带宽,也就是16GT/S,双U.2组raid0,应该能到30GT/S左右的带宽,跑够25G应该问题不大。但事实是只能到1.5~1.6GB/S左右。我暂且把它理解为这台群晖的极限。

如果说SSD阵列没有瓶颈,系统/cpu没有瓶颈,还有一种可能是网卡运行在2.0X4或者3.0X2状态,好像更符合这个测试数据;回头再研究。

在群晖上搭建speedtest测速服务,最快也只能测到1700MB/S左右,群晖孱弱的软硬件性能是公认的,估计换成MTU9000会有所改善。

机器照片:

补充:刚才远程看了一下pcie的链路状态:

网卡 ~# lspci -n -d 1077:8070 -vvv | grep --color Width

LnkCap: Port #0, Speed 8GT/s, Width x8, ASPM not supported

LnkSta: Speed 8GT/s (ok), Width x4 (downgraded)

网卡PCIE链路部分没有问题,运行在3.0x4,带宽足够25G跑满

SSD硬盘 ~# lspci -n -d 1b96:2720 -vvv | grep --color Width

LnkCap: Port #0, Speed 16GT/s, Width x4, ASPM L0s, Exit Latency L0s unlimited

LnkSta: Speed 8GT/s (downgraded), Width x2 (downgraded)

m.2插槽确实运行在X2

|

310112100042806

310112100042806