|

|

本帖最后由 godspeed66 于 2023-7-10 10:57 编辑

先上结论,10万元以下 ,2张RTX A6000 48GB,性价比最高;15万元, 系统整体性价比最高4张RTX A6000 48GB;30万元 ,2张A100 80GB

根据最近我的使用结果,基于已有LLM全参数微调

用DeepSpeed offload到CPU上,可以极大节省显存,甚至极端情况下24GB就够了

"zero_optimization": {

"stage": 3,

"offload_optimizer": {

"device": "cpu",

"nvme_path": null

},

"offload_param": {

"device": "cpu",

"nvme_path": null

},

"stage3_gather_16bit_weights_on_model_save": true

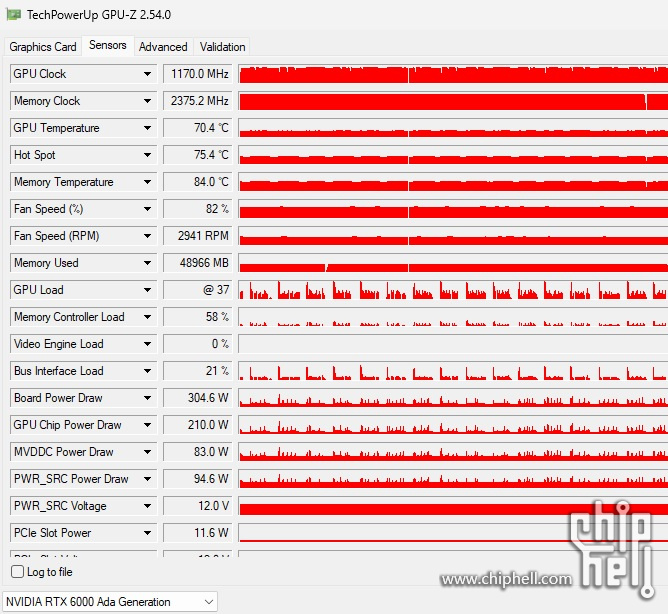

RTX6000 ADA GPU使用率在50%左右,PCI-E 4.0带宽使用率约21%,这个时候瓶颈基本在CPU单核性能上。

需要注意的是前期数据准备阶段PCI-E 4.0带宽使用率约80~85%,GPU使用率约99%,大约持续11小时。

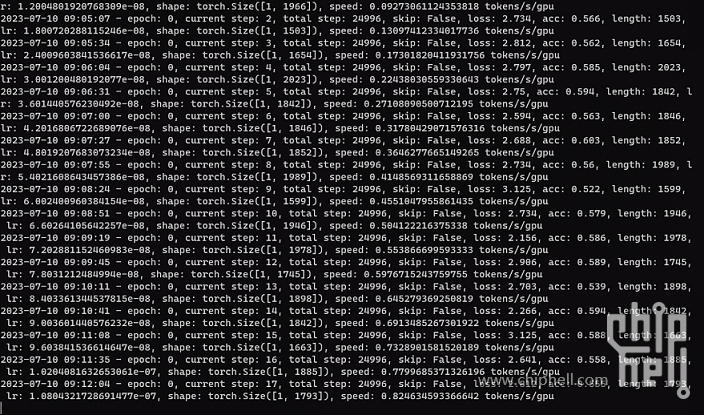

2.5万条数据,每步大约需要25~30秒(bs=1),估算每跑一遍数据大约需要大约8.7天;如果将bs=7,每步大约需要45~51秒60秒,估算每跑一遍数据大约需要大约2.1天2.5天

因为DeepSpeed offload到CPU后,瓶颈是CPU(目前暂不支持多线程),因此现阶段影响LLM全参数微调时间的因素就是显存,很明显这时高显存能带来极大的性能收益。

目前电脑支持4张显卡的计算是装机的一个瓶颈,瓶颈包含10A插座、制冷、机箱大小、稳定和物理安全等

DeepSpeed offload到CPU后:

假设每个样本需要5GB

系统成本约5万~10万:

4张RTX3090 或4张RTX4090,计算性能上整体一致(RTX4090有一定优势,但与成本明显偏高),4卡大约96GB显存,实际可用(假设6B模型),大约(24GB-6GB-6GB)*4=12GB*4 bs约等于8

2张RTX A6000,2张卡大约96GB显存,实际可用(假设6B模型),大约(48GB-6GB-6GB)*2=32GB*2 bs约等于12

目前RTX A6000 在2.75万;RTX 3090在0.85万元(怕着火只能用新的);RTX 4090 在1.5万元;

系统基本成本约2.5万,RTX A6000*2 =5.5万;RTX 3090*4=3.4万元(4卡散热、电源、组装、维护成本上升);RTX 4090*4=6万元(4卡散热、电源、组装、维护成本上升)

在这里推荐2张RTX A6000

系统成本约15万:

4张RTX A6000 或 2张RTX 6000 ADA,价格上整体一致,

4张RTX A6000 大约192GB显存,实际可用(假设6B模型),大约(48GB-6GB-6GB)*4=36GB*4 bs约等于24

2张RTX 6000 ADA大约96GB显存,实际可用(假设6B模型),大约(48GB-6GB-6GB)*2=72GB bs约等于12

1张A100 80GB,实际可用(假设6B模型),大约(80GB-6GB-6GB)*1=68GB bs约等于13

目前RTX A6000 在2.75万;RTX 6000 ADA在5.1万元;

在这里推荐4张RTX A6000

系统成本约30万:

这个该考虑A100 80GB啦,优势太大了;

1张A100 80GB,实际可用(假设6B模型),大约(80GB-6GB-6GB)*1=68GB bs约等于13

2张A100 80GB,实际可用(假设6B模型),大约(80GB-6GB-6GB)*2=68GB*2 bs约等于26

实际上2张A100 80GB 已经超神了,性能可能更强,因为支持nvlink

在这里推荐2张A100 80GB

欢迎指出我的计算错误欢迎指出我的错误,帮我进步

|

评分

-

查看全部评分

|

310112100042806

310112100042806