|

|

本帖最后由 zhuifeng88 于 2024-11-4 03:15 编辑

关于prefill

就我的使用情况而言prompt prefill是大头之一

至少我认为更实用的场景是结合相关性比较好的本地文档片段+搜索结果回答问题, 而不是让llm在没有额外上下文的情况下胡编乱造

相关性比较好的本地文档片段和搜索结果基本上会每个问题之前有至少大几千token的prefill负载进去, 然后生成几十-几百token的回答

prefill的覆盖的面远不止

"不会用LLM成天问一摸一样的问题 ,不会每天分析同一个文章来帮助自己工作学习,不会期待每个问题的答案都像WORD答案提纲一致"

任何很长的prompt, 包括多轮对话的first token响应时间吃的都是prefill, 从你贴的视频跑llama3.1 70b的片段也可以看到, m2 ultra多轮对话响应非常慢

(甚至就你的描述而言, 我觉得你是不是混淆了单纯的prefill和重用kv cache(prefill的结果), 只有后者才需要同一个文档或者同一个问题才能发挥作用, 而前者决定了不命中任何cache的情况下的TTFT

关于硬件

l20裸卡实际到手价格不含税就在2w4左右现在, 没你想的那么贵, 平台的话肯定是考虑插在现有平台上的, 所以不额外算钱, 当然不希望一定程度的自己动手就算了

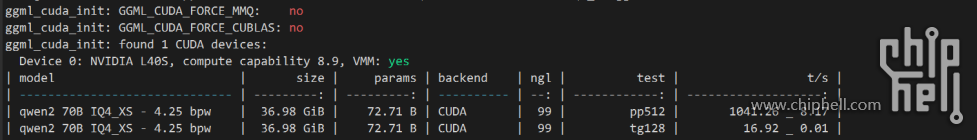

另外你贴的视频是用ollama推理的, 单任务性能是比vllm/xinference的量化推理快一点的, 在ollama下l40s(和l20一样是864GB/s带宽, 略低于6000ada)跑qwen2.5 72b 4bit是大约17token/s

当然你有很明确的移动需求的话那另说 |

|

310112100042806

310112100042806